-

- Tổng tiền thanh toán:

CPU, GPU, TPU là gì? Sự khác biệt giữa CPU với GPU và TPU

Trí tuệ nhân tạo và công nghệ Học Máy đã và đang thúc đẩy sự phát triển của các ứng dụng thông minh. Để đáp ứng với các ứng dụng ngày càng phức tạp, các công ty bán dẫn không ngừng phát triển các bộ vi xử lý bao gồm CPU, GPU và TPU. Tuy nhiên, với định luật Moore đang có xu hướng bị chậm lại, chỉ riêng hiệu suất của CPU sẽ không đủ để thực hiện các khối lượng công việc đòi hỏi một cách hiệu quả. Vấn đề là, làm thế nào các công ty có thể tăng tốc hiệu suất của toàn bộ hệ thống để hỗ trợ các công việc nặng cho ứng dụng AI? Câu trả lời có thể đến thông qua sự phát triển của GPU và TPU để bổ sung cho CPU trong chạy các mô hình học sâu (Deep learning), Machine learning và AI. Đó là lý do tại sao điều cần thiết là phải hiểu các công nghệ đằng sau CPU, GPU và TPU để bắt kịp với các công nghệ liên tục phát triển để có hiệu suất và hiệu suất tốt hơn.

CPU, GPU và TPU

Về cơ bản, điều khác biệt giữa CPU, GPU và TPU là CPU là đơn vị xử lý hoạt động như bộ não của một máy tính được thiết kế để lý tưởng cho lập trình mục đích chung. Ngược lại, GPU là một bộ tăng tốc hiệu suất giúp tăng cường đồ họa máy tính và khối lượng công việc AI. Trong khi TPU là bộ xử lý do Google phát triển tùy chỉnh để tăng tốc khối lượng công việc học máy bằng cách sử dụng TensorFlow (khuôn khổ học máy cụ thể).

CPU là gì?

CPU tên gọi khác Bộ xử lý trung tâm (Central Processing Unit) là bộ xử lý cốt lõi tồn tại trong tất cả các thiết bị thông minh của bạn. CPU là một bộ xử lý đa năng được thiết kế với một hoặc nhiều lõi mạnh mẽ và bộ nhớ đệm lớn cho phép nó chạy nhiều luồng phần mềm cùng một lúc. CPU giống như một nhạc trưởng trong dàn nhạc; nó điều khiển tất cả các thành phần khác từ bộ nhớ đến card đồ họa để thực hiện nhiều chức năng xử lý cho hệ thống.

CPU có ít nhất một lõi xử lý nhưng đã phát triển theo thời gian để ngày càng có nhiều lõi hơn. Có một số lõi cho phép CPU có khả năng thực hiện đa luồng, một công nghệ cho phép CPU thực hiện hai dòng thực thi (luồng) cùng một lúc trên một lõi duy nhất. Hơn nữa, các CPU hiện đại hiện nay có từ hai đến sáu lõi và một số thậm chí có từ tám đến 64 lõi đối với các CPU cấp doanh nghiệp thường dành cho trung tâm dữ liệu.

Tính năng

- Có nhiều hơn một lõi

- Độ trễ thấp

- Chuyên xử lý nối tiếp

- Có khả năng thực hiện một số hoạt động cùng một lúc

- Có mức sử dụng FLOPS cao nhất cho Mạng nơron hồi quy (Recurrent Neural Network – RNNs)

- Hỗ trợ mô hình lớn nhất nhờ dung lượng bộ nhớ lớn

- Linh hoạt hơn nhiều và có thể lập trình cho các tính toán không thường xuyên (ví dụ: các tính toán hàng loạt nhỏ không phải phép nhân ma trận (matrix multiplication))

GPU là gì?

GPU (Bộ xử lý đồ họa – Graphics Processing Unit) là bộ xử lý các tác vụ có liên quan tới đồ họa. GPU được xem là một bộ xử lý chuyên dùng để giải quyết những vấn đề liên quan tới khả năng hiển thị hình học của máy tính. Bộ phận này đảm bảo các tác vụ liên quan tới hình ảnh hay hình khối. GPU liên kết mật thiết với vi xử lý trung tâm CPU. So với CPU, GPU có hàng nghìn lõi có thể chia các vấn đề phức tạp thành hàng nghìn hoặc hàng triệu tác vụ riêng biệt và giải quyết chúng song song. Tính toán song song sử dụng hàng nghìn lõi GPU để tối ưu hóa các ứng dụng khác nhau, bao gồm xử lý đồ họa, kết xuất video, Học máy và thậm chí khai thác cho các loại tiền điện tử như Bitcoin.

Trong thập kỷ qua, GPU đã trở thành một bộ phận thiết yếu để phát triển các ứng dụng Học sâu. Với khả năng tăng tốc các tính toán ma trận lớn và thực hiện các phép tính ma trận có độ chính xác cao trong một thao tác duy nhất, GPU có thể đẩy nhanh quá trình học sâu ở tốc độ cao. Công nghệ điện toán song song này làm cho GPU trở thành một phần quan trọng của siêu máy tính hiện đại, thúc đẩy sự bùng nổ AI trên toàn thế giới.

Tính năng

- Có hàng nghìn lõi

- Thông lượng cao

- Chuyên dùng để xử lý song song

- Có khả năng thực hiện hàng nghìn thao tác cùng một lúc

TPU là gì?

TPU là viết tắt của Tensor Processing Unit, là các mạch tích hợp dành riêng cho ứng dụng (ASIC). TPU được thiết kế từ đầu bởi Google; họ bắt đầu sử dụng TPU vào năm 2015 và công khai vào năm 2018. TPU có sẵn dưới dạng đám mây hoặc phiên bản nhỏ hơn của chip. Các TPU đám mây cực kỳ nhanh trong việc thực hiện các phép tính vectơ và ma trận dày đặc để tăng tốc Học máy – neural network trên phần mềm TensorFlow. TensorFlow là một nền tảng Học máy mã nguồn mở do Nhóm Google Brain xây dựng để giúp các nhà phát triển, nhà nghiên cứu và doanh nghiệp chạy và vận hành các mô hình AI trên các API TensorFlow cấp cao được hỗ trợ bởi phần cứng Cloud TPU. TPU giảm thiểu thời gian chính xác trong việc đào tạo các mô hình mạng nơ-ron lớn và phức tạp. Với TPU, các mô hình học sâu trước đây mất hàng tuần để đào tạo trên GPU giờ chỉ mất hàng giờ đối với TPU.

Tính năng

- Phần cứng đặc biệt để xử lý ma trận

- Độ trễ cao (so với CPU)

- Thông lượng rất cao

- Tính toán với cực song song

- Được tối ưu hóa cao cho các lô lớn và Mạng nơ-ron tích chập (Convolutional Neural Network – CNNs)

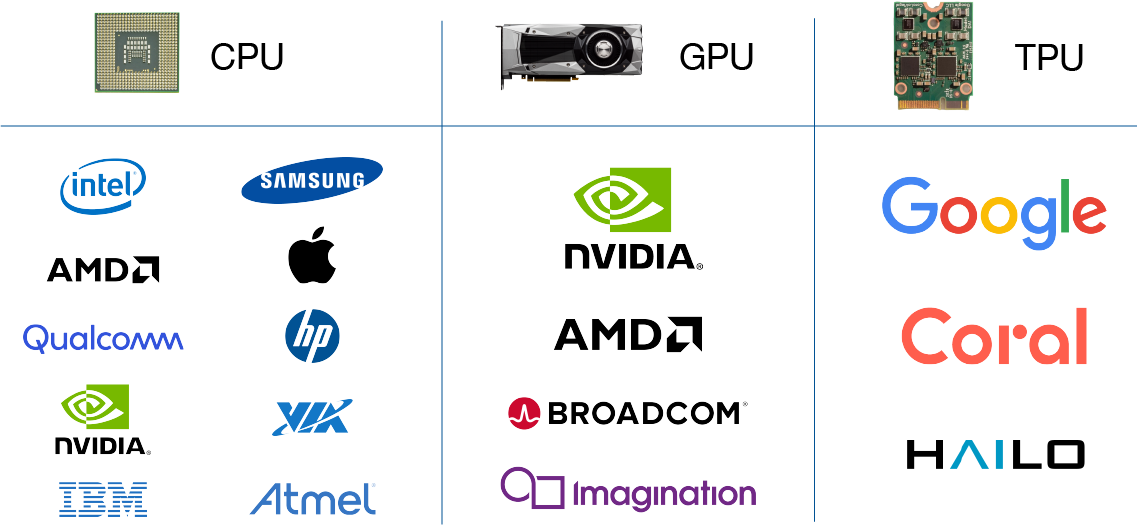

Các nhà sản xuất CPU, GPU và TPU tiêu biểu

- Các nhà sản xuất CPU: Intel, AMD, Qualcomm, NVIDIA, IBM, Samsung, Apple, VIA, Atmel,…vv

- Các nhà sản xuất GPU: NVIDIA, AMD, Broadcom Limited, Imagination Technologies (PowerVR),..vv

- Nhà sản xuất TPU: Google, Coral (thuộc sở hữu của Google), HAILO

Ngoài ra còn có rất nhiều nhà sản xuất khác. Các bạn có thể tham khảo thêm tại đây

Cách CPU, GPU và TPU kết nối với bo mạch chủ?

Bo mạch chủ là một bảng mạch đóng vai trò là trung gian giao tiếp giữa các thiết bị với nhau từ CPU, bộ nhớ – RAM, ổ cứng lưu trữ,… và các đầu nối cho các thiết bị ngoại vi khác. Bo mạch chủ là nơi tất cả CPU, GPU và TPU được kết nối để giao tiếp với các thành phần điện tử khác của hệ thống.

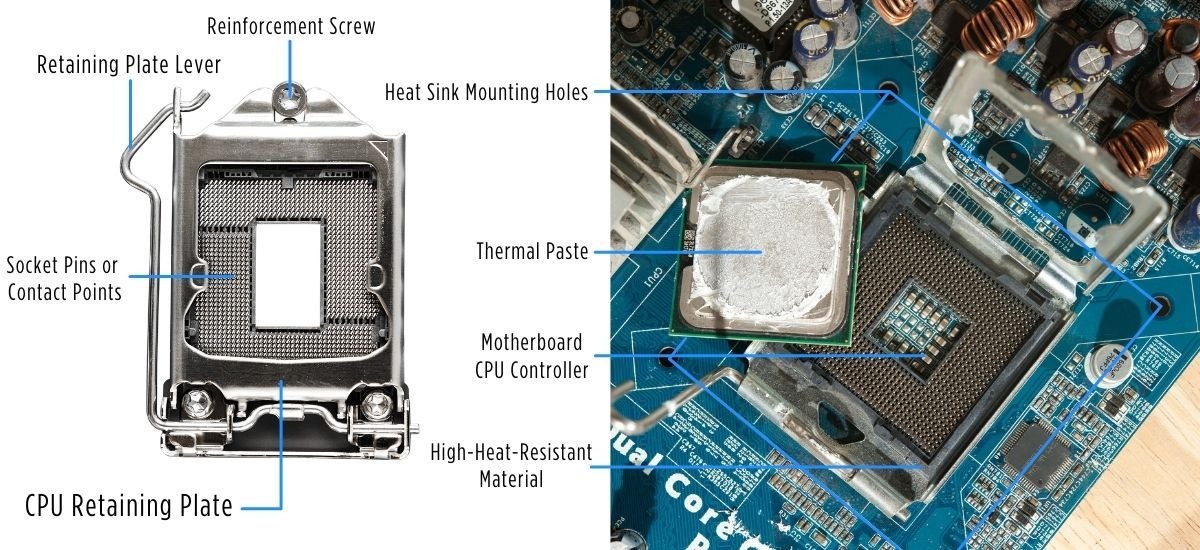

- CPU kết nối với bo mạch chủ

Có hai loại CPU cơ bản là CPU socket và CPU tích hợp SoC (system on chip). Socket CPU được cài đặt trên khe cắm CPU của bo mạch chủ. Các socket CPU được xây dựng với hàng nghìn điểm tiếp xúc dưới dạng chân kim loại để truyền nguồn và dữ liệu giữa CPU với bo mạch chủ. Các socket CPU được kết nối thông qua giao diện vật lý Land grid array(LGA) hoặc Pin grid array (PGA). Mặt khác, SoC là một chipset độc đáo đã đưa CPU với các thiết bị ngoại vi thiết yếu khác như bộ nhớ và bộ xử lý đồ họa vào một chip silicon duy nhất. Các SoC thường được hàn ngay trên bo mạch chủ với kết nối Ball grid array (BGA) và cung cấp mức tiêu thụ điện năng thấp cho IoT và các ứng dụng di động.

- GPU kết nối với bo mạch chủ

GPU có hai loại cơ bản: card đồ họa GPU rời và card đồ họa GPU tích hợp (onboard). GPU rời là một bộ xử lý đồ họa riêng biệt, được tách biệt với CPU. Các GPU rời thường được gắn vào khe PCI Express x16 trên bo mạch chủ. Ngược lại, GPU tích hợp được nhúng cùng với CPU trên mạch tích hợp SoC.

- Cách TPU kết nối với bo mạch chủ

Vào đầu năm 2019, Google cuối cùng đã phát hành phần cứng TPU mà bạn có thể mua từ thương hiệu Coral của họ. Thông số kỹ thuật hiện tại cho các đơn vị TPU bạn có thể mua có thể thực hiện 4 nghìn tỷ hoạt động mỗi giây (Trillion operations per second – TOPS). Có ba loại phần cứng TPU mà bạn có thể nhận được ngày hôm nay:

- TPU USB có tính năng Edge TPU thông qua kết nối cáp USB.

- Các TPU kết nối thông qua kết nối mPCIe hoặc M.2 (A + E và B + M key). Các đầu nối M.2 và mPCIe cho phép các TPU được gắn trực tiếp vào bo mạch chủ.

- Tùy chọn TPU Dev Board là một máy tính một bo mạch với hệ thống system-on-module (SoM) có thể tháo rời cho các ứng dụng AI mô-đun.

Các công nghệ xử lý khác nhau mang lại những lợi thế khác nhau tùy thuộc vào ứng dụng cụ thể. Công nghệ mới đang phát triển nhanh chóng, điều quan trọng là phải cập nhật những cải tiến mới nhất của công nghệ điện toán khi ngành công nghiệp bán dẫn và AI không ngừng phát triển theo cấp số nhân.